⼈⼯智能虽持续占据新闻头条,但其未来发展的⼀项核⼼制约因素却仍未得到充分重视:散热。

随着GPU 与ASIC 的功耗突破1500 ⽡、向2000 ⽡乃⾄更⾼⽔平迈进,散热已成为决定 AI 系统实际性能输出的关键因素。热极限如今直接影响着持续token 吞吐量、能源效率、⽔资源消耗、部署灵活性以及总拥有成本。

散热不再仅仅是AI 的⽀撑环节,它正⽇益塑造着AI 的可能性边界,是释放⼈⼯智能真正潜⼒的核⼼前提。这⼀转变⽆处不在:⽆论是地⾯超⼤规模数据中⼼,还是尚处早期规划阶段的太空数据中⼼,热管理都已成为地⾯数据中⼼的关键任务需求,并在太空数据中⼼的相关讨论中占据主导地位。在太空环境中,热管理的重要性将进⼀步提升。

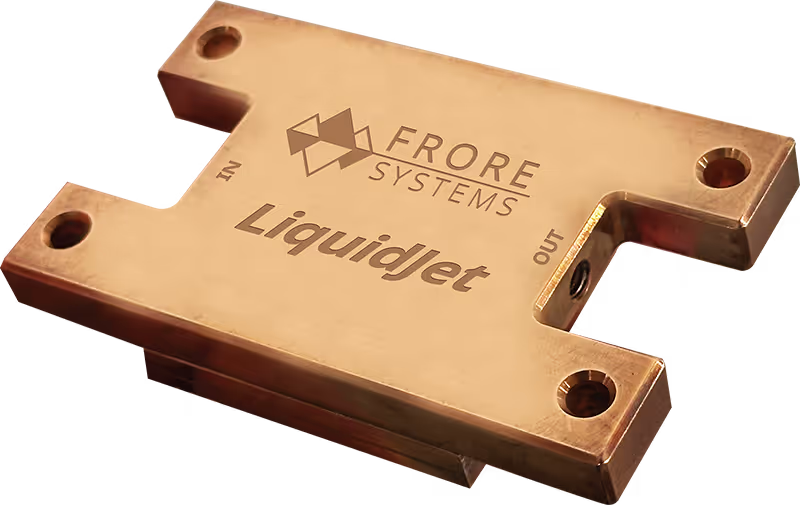

正如Frore Systems 创始⼈兼⾸席执⾏官Seshu Madhavapeddy 近期所⾔:

散热已悄然成为制约AI 发展的最⼤瓶颈之⼀。随着GPU 与ASIC 迈⼊全新功耗区间,⾏业⽆法再依赖传统冷板的渐进式改进。LiquidJet 从底层架构出发进⾏设计,以匹配现代 AI 芯⽚的热特性现实,我们的⽬标不仅是实现有效散热,更是为解锁下⼀代AI 能⼒铺路。

这⼀观点反映了⾏业的普遍共识:散热不再只是⼀项⼯程任务,⽽是⾸要的基础设施决策。

散热已成性能制约瓶颈

在现代AI 系统中,热极限对实际性能的主导作⽤⽇益凸显。当芯⽚结温⽆法维持在安全运⾏范围内时,系统会被迫降频,效率随之下降,下⼀代GPU 与ASIC 带来的理论性能提升将沦为边际效益递减。这并⾮理论挑战,⽽是实际运营中必须⾯对的问题。

散热决策如今直接影响以下核⼼维度:

- 持续性能与系统正常运⾏时间

- 能源效率与运营成本

- ⽔资源消耗与基础设施需求

- 机架密度与部署灵活性

- ⻓期总拥有成本

简⽽⾔之,散热的核⼼⽬标已从防⽌系统故障,转变为⽀撑规模化部署。

传统散热架构为何遭遇瓶颈

传统冷板的设计理念源于算⼒发展的另⼀时代:彼时功耗更低、热量分布更均匀,热点密度可通过相对简单的散热⽅案进⾏管控。但那个时代早已成为过去。

现代AI 加速器具有⾼度局部化的热点、复杂的功耗图谱,以及极具挑战性的性能⽬标,这些都是传统散热架构从未针对其设计的场景。其结果是,数据中⼼运营商被迫做出艰难

妥协:要么限制性能输出,要么过度建设基础设施,要么接受⾼成本、⾼环境影响的低效率⽅案。

问题的根源不在于执⾏层⾯,⽽在于现有冷板的架构设计。

⾯向现代AI 的全新散热⽅案

LiquidJet 采⽤了⼀种从根本上截然不同的散热思路,专为现代AI 芯⽚的特性与现代数据中⼼的经济模型量⾝打造。

不同于对为低功耗、均匀热分布设计的传统冷板进⾏适应性改造,Frore Systems 将半导体级制造技术应⽤于这⼀突破性散热解决⽅案。通过⾦属晶圆、3D 短回路喷射通道微结构、多级冷却架构以及混合3D 单元结构, LiquidJet 能够精准匹配当前GPU 的实际热分布图谱,⽽⾮仅仅针对其平均功 耗⽔平。

这使得散热性能能够根据热量产⽣的位置与⽅式进⾏扩展,在不迫使运营商过度建设或重新设计设施的前提下,实现更⾼的持续性能。同样重要的是,LiquidJet ⽆需昂贵的基础设施改造即可实现上述能⼒。作为⼀款即插即⽤的芯⽚直连式升级⽅案,它可在现有液冷回路与数据中⼼环境中直接部署。

运营商⽆需进⾏⼤规模翻新、采⽤新型管道架构或经历漫⻓的部署周期,即可从现有系统中解锁更⾼性能。LiquidJet 使数据中⼼能够提升现有基础设施的价值,同时跟上下⼀代 AI 加速器的发展步伐。散热不必成为AI 发展的绊脚⽯,也不必让规模化部署的成本⾼得令⼈却步。

正如Seshu 所阐释:

传统冷板的设计从未考虑过当今AI 加速器的热点分布特征。LiquidJet 将半导体级制造技术应⽤于散热领域,使我们能够精准靶向热量产⽣的位置。这⼀转变,正是满⾜当前AI 基础设施对性能、效率与可扩展性需求的关键。

近期LiquidJet 在下⼀代GPU,包括Blackwell Ultra 与Rubin 级架构上的演⽰验证,进⼀步强化了⾏业的共识:散热创新必须与芯⽚创新同步发展。

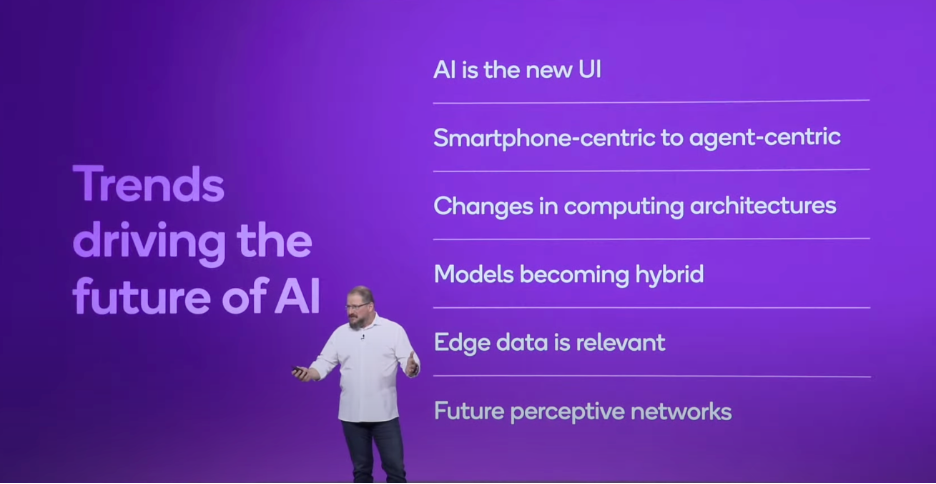

散热正成为AI 系统级战略决策

这⼀趋势的深层意义,已超越了任何单⼀散热技术本⾝。散热不再是设计周期后期才做出

的组件选择,⽽是⼀项系统级决策,其影响贯穿始终:

- AI 平台的架构设计⽅式

- AI 平台的可部署场景

- AI 平台⻓期规模化的效率

随着AI 基础设施在地⾯乃⾄太空不断扩展,智能、⾼效、可持续的热管理能⼒,将⽇益成为决定竞争优势的核⼼要素。在AI 时代,散热⾄关重要。它不仅是⼀项战略决策,更是塑造AI 基础设施未来的最关键选择之⼀。

更凉爽的GPU 与ASIC → 更⾼的持续性能 → 更强的AI 能⼒