人工智能革命并非 “即将到来”—— 它已落地生根,且发展速度远超以往任何技术浪潮。模型规模持续膨胀,推理需求急剧攀升,数据中心正全力突破单机柜性能的历史上限。然而,就在性能飞速提升的同时,一道物理瓶颈也随之浮现。

这个性能瓶颈并非算力本身,而是散热。

多年来,人工智能性能的提升主要依赖于更强大的 GPU 与加速器、更高密度的机柜,以及能耗更高的工作负载。但这一性能提升背后,隐藏着一个被忽视的 “散热成本”:每 1 瓦的算力消耗,最终都会转化为 1 瓦的热量。而要从密度越来越高的芯片中带走这些热量,当前的散热基础设施正逐渐逼近极限。

行业对 “增长” 的认知正发生一场悄无声息却至关重要的转变:

散热已成为新的增长瓶颈。

日益严峻的能源压力

德勤(Deloitte)近期发布的报告《美国基础设施能否跟上人工智能经济的步伐?》(Can US infrastructure keep up with the AI economy?)警告称:在核心区域,人工智能带来的电力需求已超过电网可用容量,为数据中心的扩张设置了重大障碍。而散热系统 —— 包括冷却泵、冷水机和流体回路 —— 正是电力消耗的 “大头” 之一。

与此同时,麦肯锡公司(McKinsey & Company)在《算力成本:一场规模达 7 万亿美元的数据中心扩张竞赛》(The cost of compute: A $7 trillion race to scale data centers)中预测:要扩建算力基础设施以满足未来人工智能需求,全球需投入高达 7 万亿美元的资金。这绝非仅与 GPU 相关的投入 —— 散热与能源系统已深度融入成本结构:每节省 1 瓦电力、简化 1 条回路、降低 1 份压降,每提升 1 分散热效率,都将直接影响最终收益。

斯坦福大学以人为本人工智能研究所(Stanford Institute for Human-Centered Artificial Intelligence)发布的《2025 年人工智能指数报告》则勾勒出宏观趋势:模型复杂度与算力需求正呈指数级增长,而非线性增长。传统的基础设施方案已难以跟上这一节奏

为何大规模场景下散热系统濒临失效

如今,最先进的人工智能加速器所产生的热密度,在几年前还难以想象。功率达 1.4 千瓦的 GPU 已属常规,而未来 NVIDIA Feynman 系列 GPU 的功率更是将突破 4.0 千瓦。芯片热点区域的功率密度正急剧飙升。

传统的切削式 2D 微通道冷板,本就不是为这样的场景设计的。它们需要高冷却液流量才能散热,会产生巨大的压降,且难以应对局部热点的功率波动。

传统的切削式 2D 微通道冷板,本就不是为这样的场景设计的。它们需要高冷却液流量才能散热,会产生巨大的压降,且难以应对局部热点的功率波动。

在大规模部署中,这些缺陷会迅速放大:

- 需更多泵体与能源维持流量

- 管路系统复杂度更高

- 数据中心运营商面临更高的总拥有成本(TCO)

- 最关键的是:散热上限会限制芯片性能的发挥

曾经的 “工程细节问题”,如今已升级为 “管理层决策问题”。若散热无法跟上,人工智能基础设施的扩张便会陷入停滞。

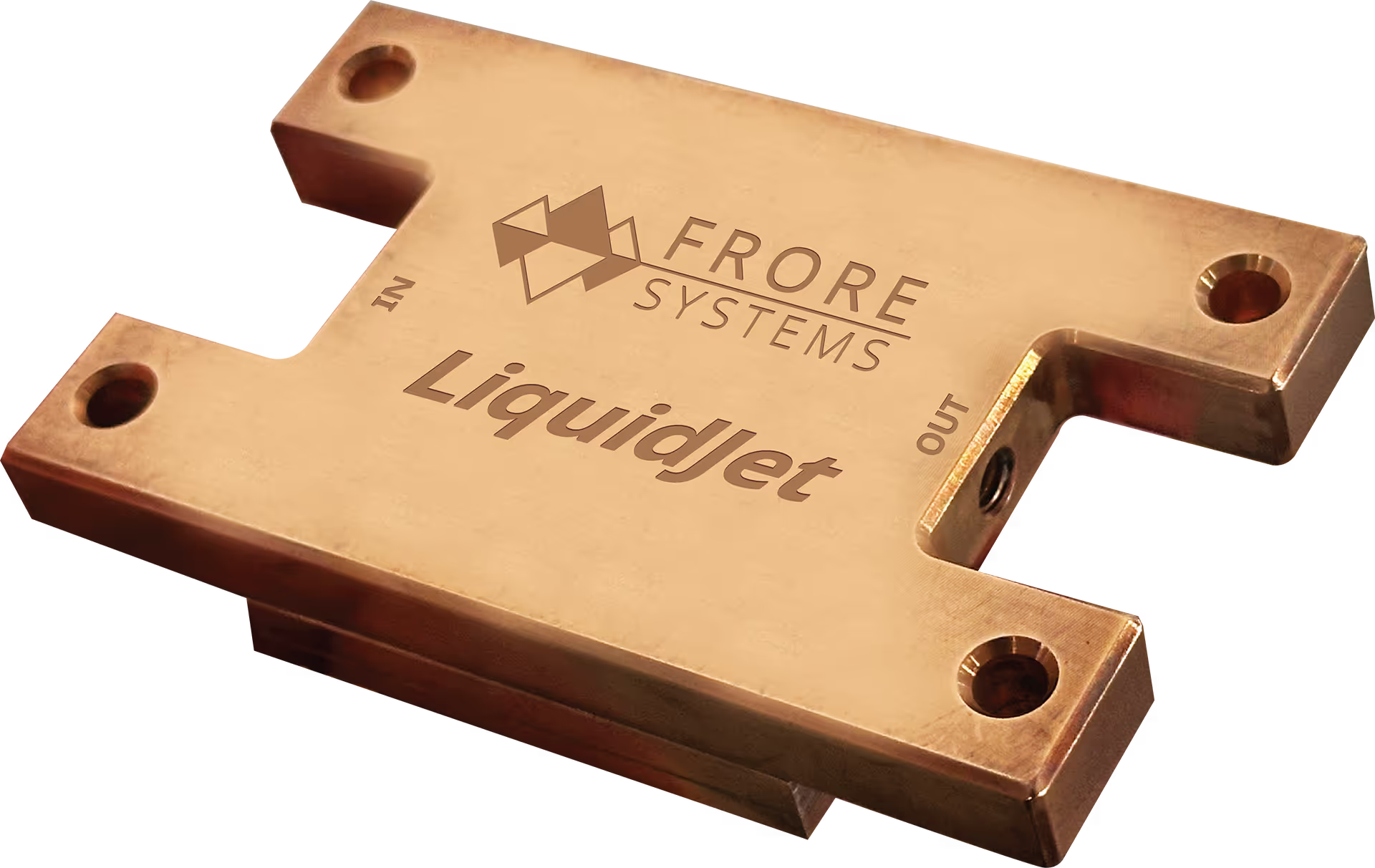

LiquidJet 登场:为人工智能时代重塑散热技术

LiquidJet 是一款专为突破这一瓶颈设计的下一代精密冷板。其核心突破在于 3D 短回路喷射通道微结构 —— 这一行业首创设计,彻底颠覆了传统散热的性能上限。

LiquidJet 实现了以下突破:

- 热点功率密度提升 2 倍 —— 在入口温度 40℃、界面材料(TIM)热阻 0.02℃・平方厘米 / 瓦的条件下,可达 600 瓦 / 平方厘米

- 散热效率(千瓦 / 升・分钟)提升 50%—— 用更少冷却液带走更多热量,实现单机柜更高芯片密度

- 压降降低 4 倍,泄漏风险显著降低

- 定制化设计 —— 可与任意系统级芯片(SoC)或 GPU 的功率分布精准匹配

- 即插即用升级 —— 无需改动现有液冷基础设施

传统冷板每移除 1 千瓦热量,通常需要约 1.4 升 / 分钟的冷却液流量;而 LiquidJet 仅需 1 升 / 分钟的流量,即可实现同等散热效果。通俗地说:它能用更少的资源实现更多的功能。这意味着更低的泵送能耗、更低的运营成本,以及更高的机柜密度。

问题一:供电系统承压

人工智能的增长正与电网容量极限正面碰撞。

德勤(Deloitte)的基础设施分析揭示了一个残酷现实:电网运营商难以跟上数据中心的扩张速度。在部分区域,申请新供电连接的等待时间长达数年。而散热系统,正是数据中心中非算力相关的最大能耗来源之一。

LiquidJet 直接攻克了这一瓶颈。通过降低流量需求与压降,它大幅减少了冷却回路的能耗。泵送冷却液所需的电力更少,能源浪费更少,机柜设计也更具可持续性。

这种高效性能在现有电网配额内释放出 “额外空间”,让运营商无需等待新供电基础设施建成,即可先行扩建算力。

散热效率即电能效率,而电能效率即增长空间。

问题二:资本成本激增

扩建人工智能基础设施的成本极高,而散热成本已深度融入其中。

麦肯锡 7 万亿美元的预测,凸显了这一问题的重要性。随着数据中心为支撑超大规模人工智能工作负载而扩张,每一个能简化基础设施或降低 TCO 的组件,在数千个机柜的规模下,都将产生巨大的成本优化效应。

传统切削式 2D 微通道冷板需要大型泵站、复杂的集管系统,以及昂贵的管路架构来应对高压降 —— 这种复杂性最终都会转化为资本支出(CapEx)。

LiquidJet 大幅降低的压降,带来了以下优势:

- 单条回路可连接更多加速器

- 泵送系统更简单、体积更小

- 安装与维护成本更低

对于大规模人工智能部署而言,这绝非 “小幅优势”—— 而是 “每瓦冷却算力成本” 的结构性变革。

问题三:算力需求指数级增长

散热曲线正落后于算力曲线。

斯坦福大学《人工智能指数报告》揭示了一个行业共识:算力需求正呈指数级增长。芯片功率逐年攀升 —— 从每芯片 1.4 千瓦突破至 4 千瓦以上,而机柜密度还在不断提高。

这意味着散热系统必须在 “更小空间、更少能源” 的前提下,实现 “更强散热”。

这正是 LiquidJet 的优势所在。它能像外科手术般精准靶向热点,最大化每升冷却液的散热效率,同时降低压降 —— 无需依赖复杂的双相散热系统,也无需大规模改造基础设施,即可为下一代机柜的部署铺平道路。

LiquidJet 绝非一款普通的冷却设备,而是人工智能时代的 “增长赋能者”。

为何当下至关重要

人工智能基础设施的扩张竞赛并未减速。企业、超大规模数据中心运营商与政府正投入数万亿美元扩建算力。但在这一增长故事背后,隐藏着一个令人不安的事实:若散热技术的创新速度跟不上芯片,增长曲线终将趋于平缓。

- 数据中心运营商面临能源配额限制

- 开发者面临芯片热降频问题

- 整个行业面临成本螺旋式上升

LiquidJet 提供了一条不同的发展路径 —— 在这条路径上,散热不再是瓶颈,而是 “效能倍增器”。通过消除散热与能源障碍,它为算力的持续指数级增长创造了空间,且无需让成本与碳足迹同步攀升。

宏观视角:散热成为战略性基础设施

我们往往将 GPU、加速器、内存与网络视为人工智能基础设施的 “主角”。但每 1 拍次(petaflop)的算力背后,都伴随着 1 瓦需要被带走的热量。

散热不再是 “事后考虑的细节”,而是 “战略性杠杆”—— 它决定着人工智能革命能以多快的速度、多大的规模推进。

正如我们的创始人兼首席执行官 Seshu Madhavapeddy 反复强调的:

“散热架构,是人工智能未来发展的基石。"

LiquidJet 的设计初衷,正是为了应对这一关键转折点。它的高效性、热点散热能力与易集成性,让运营商能够 “即刻扩张”—— 而非等待数年后,其他复杂散热方案追赶上来。

展望未来

我们正进入一个 “每 1 瓦都至关重要” 的时代。未来数据中心的效率,将不再仅由算力决定 —— 更由我们 “如何智慧地管理热量” 决定。

LiquidJet 不仅实现了 “更好的散热”,更在重塑大规模人工智能基础设施的 “可能性边界”

试想这样一个行业:

- 电力不再是限制因素

- 散热设计与芯片创新同步推进

- 人工智能扩张不再是 “7 万亿美元的难题”,而是一条可持续的增长之路

这,就是 LiquidJet 正在开启的未来。

参考资料

- 德勤,《人工智能热潮下的数据中心基础设施》:

https://www.deloitte.com/us/en/insights/industry/power-and-utilities/data-center-infrastructure-artificial-intelligence.html - 麦肯锡公司,《算力成本:一场规模达 7 万亿美元的数据中心扩张竞赛》:

https://www.mckinsey.com/industries/technology-media-and-telecommunications/our-insights/the-cost-of-compute-a-7-trillion-dollar-race-to-scale-data-centers - 斯坦福大学以人为本人工智能研究所,《2025 年人工智能指数报告》:

https://hai.stanford.edu/ai-index/2025-ai-index-report